在上一期的《JMP测量系统分析(MSA)系列之一》中,我们为大家介绍了入门级的传统计量型测量系统的分析过程,而当过程的输出特性为计数型数据时,即测量值为一组有限的分类数,最常见的如合格/不合格,一等品/二等品/三等品/…时,此类测量系统的分析方法显然将会有所不同。目前,对于计数型测量系统多采用一致性比率和Kappa值来进行分析,本文的重点就是向大家介绍如何应用JMP来进行辅助评估。

其中,一致性比率是度量分类测量结果一致性最常用,也是最通俗易懂的一个统计量,用公式来描述即:

而Kappa值(κ)则是另一个度量分类测量结果一致性的统计量,并且比较常见的是Cohen κ,它适用于度量两个变量具有相同的分级数和分级值时的吻合程度。用公式来描述即:

式中,P0为实际一致的比率;Pe为期望一致(随机猜对)的比率。

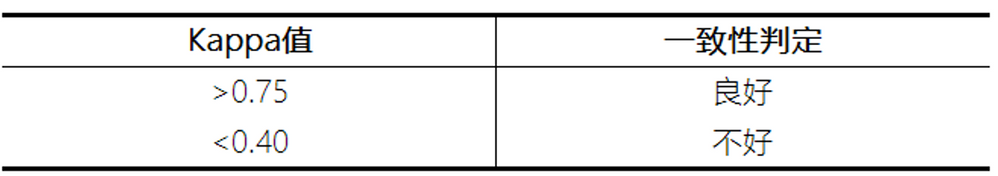

如果你觉得Kappa公式有些难以理解的话,不妨按照以下定性理解即可。假设我们要评估两个评级员对30个部件合格与否的测量结果的一致性,试想一下,即使两个评级员不严格贯彻标准作业流程,只是分别随意给出30个评级测量结果,那么也可以获得两者在某种程度上的一致性,那么,所谓kappa值就是扣除了这部分随机不确定成分后的一致性结果,因此,相对更为准确。在这里,作为应用者,我们不必过于纠结Kappa值的计算过程,因为在JMP等现代统计分析软件的辅助下都可直接给出相应的计算结果,你只需要会对结果进行解释和判定即可。一般情况下,-1≤κ≤1,当κ=1时,表示两者完全一致;当κ=-1时,表示两者截然相反;当κ=0时,表示两者一致程度跟瞎蒙差不多。此外,在AIAG MSA手册中,其建议参考标准如表-1所示。

表-1 Kappa值的一般判定标准

接下来,为了避免不必要的分歧,我们直接引用AIAG MSA手册 (第4版,英文版),Chapter Ⅲ,Section C,Attribute Measurement Systems Study,P131-140中的案例,来对计数型测量系统分析的操作过程予以演示,并对输出结果予以简析。

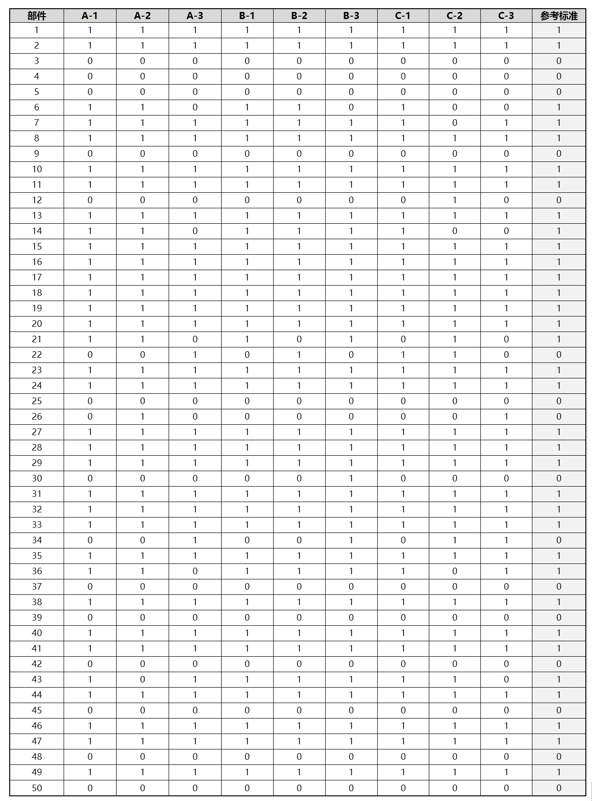

“50个代表性部件,3个评级员,每个部件每人测3次的计数型数据汇总如表-2所示。

- “1”表示部件合格或接受

- “0”表示部件不合格或拒绝

- 代表性部件的抽样细节其实蛮关键,比如50%左右的部件应该来自于“灰色”地带(即临近规格上下限的临界地带),而剩余部件则应为明确的合格品与不合格品各半

- 检测者应实施盲测,以避免人为主观因素影响测量数据的真实性”

表-2 计数型测量系统分析数据集

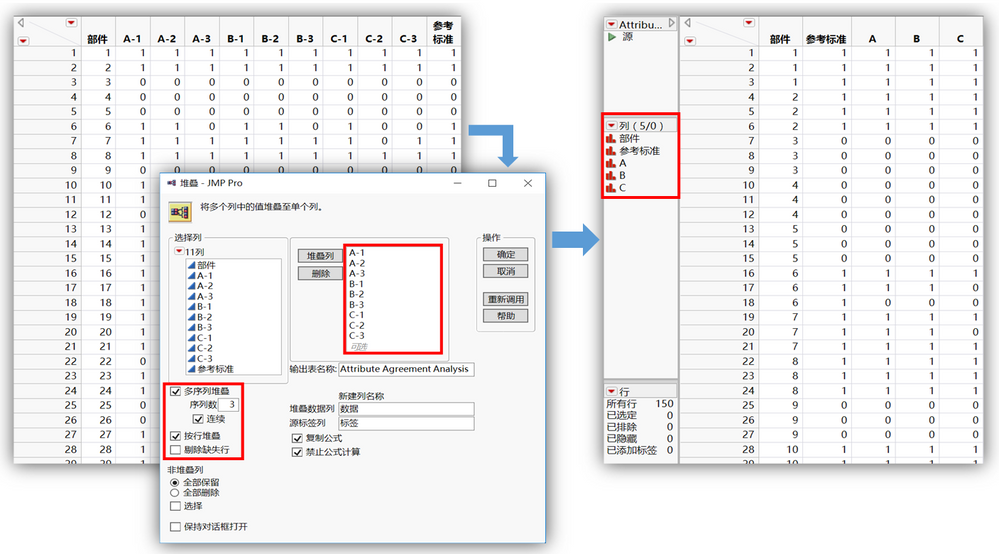

JMP针对本例的计数型测量系统的分析操作步骤:

- 首先,在源数据导入至JMP后,利用堆叠平台并稍加整理,即可轻松转换数据结构至图-1所示形式,并且最终变量类型都应设置为名义型变量。

图-1 计数型测量系统分析数据的录入和整理

图-1 计数型测量系统分析数据的录入和整理

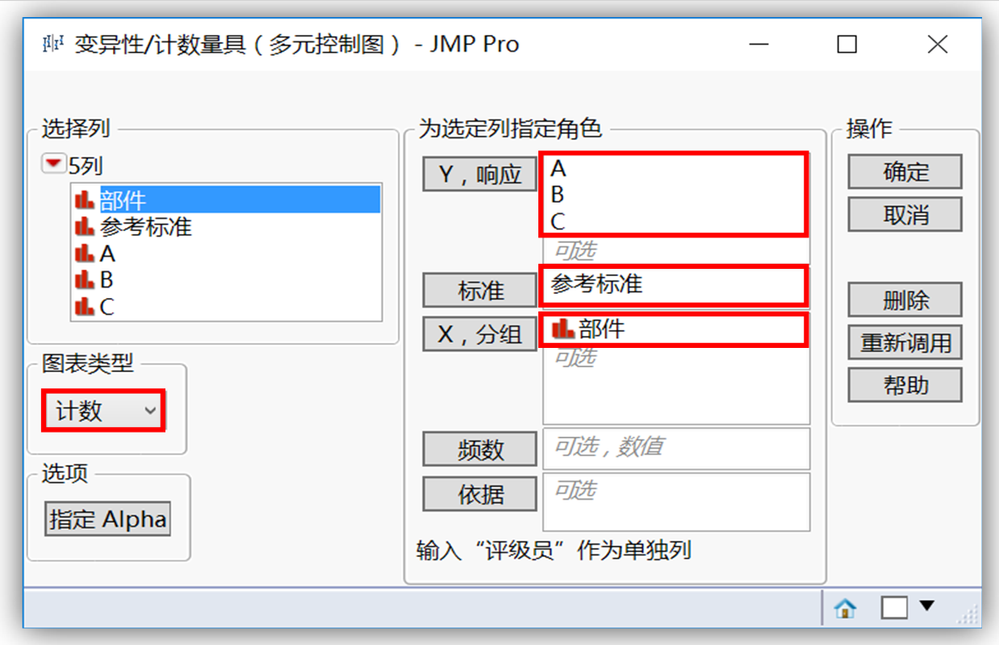

- 按图-2设置,启动“分析>质量和过程>变异性/计数量具图”平台。

图-2 “变异性/计数量具图”启动平台设置

- 点击确定之后,后续主要工作便是对计数型测量系统分析输出报表的系列解析,依据AIAG MSA手册的指南,它主要包括以下几个方面:

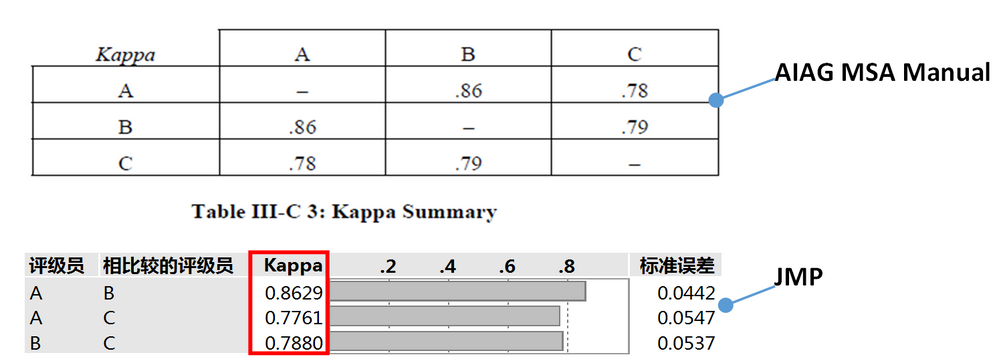

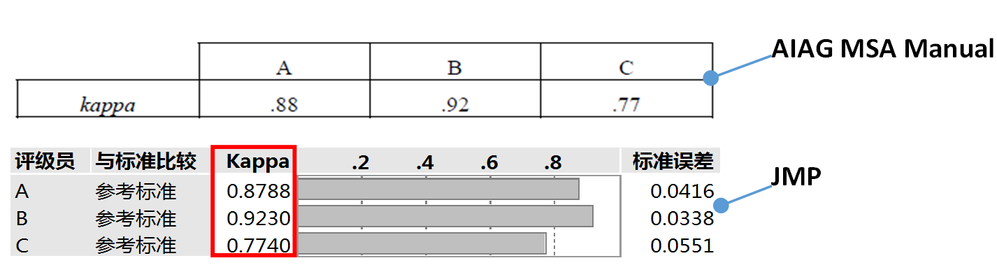

- 基于Kappa值,评估评级员之间是否具有良好的一致性,结果如图-3所示。从中可以看出,由于Kappa值全部>0.75,因此认为评级员之间具有良好的一致性。

图-3 不同评级员之间Kappa值汇总

- 基于Kappa值,评估评级员和参考标准之间是否具有良好的一致性,结果如图-4所示。从中可以看出,由于Kappa值全部>0.75,因此认为评级员和参考标准之间也具有良好的一致性。

图-4 不同评级员和参考标准之间Kappa值汇总

- 在评估了评级员之间、评级员和参考标准之间的一致性后,还可基于一致性比率评估每个评级员的测量有效性、误报率和漏报率。

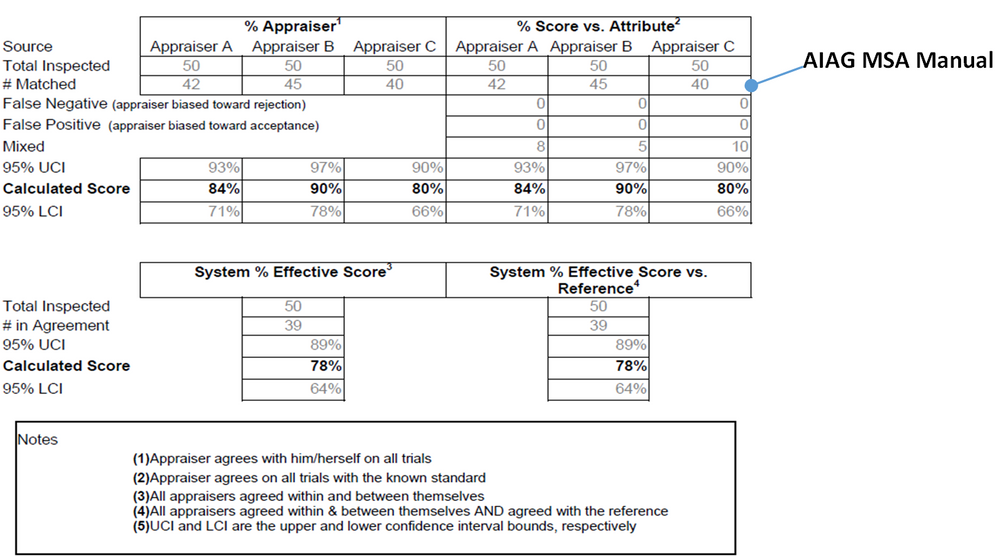

首先,如图-5所示,在AIAG MSA手册中,该环节评估了以下4个方面:

- 在所有测量中,评级员本身的一致性

- 评级员的所有测量和参考标准的一致性

- 所有评级员本身与其他评级员之间一致,且与参考标准一致的情况

图-5 AIAG MSA手册计数型测量系统分析有效性研究汇总表

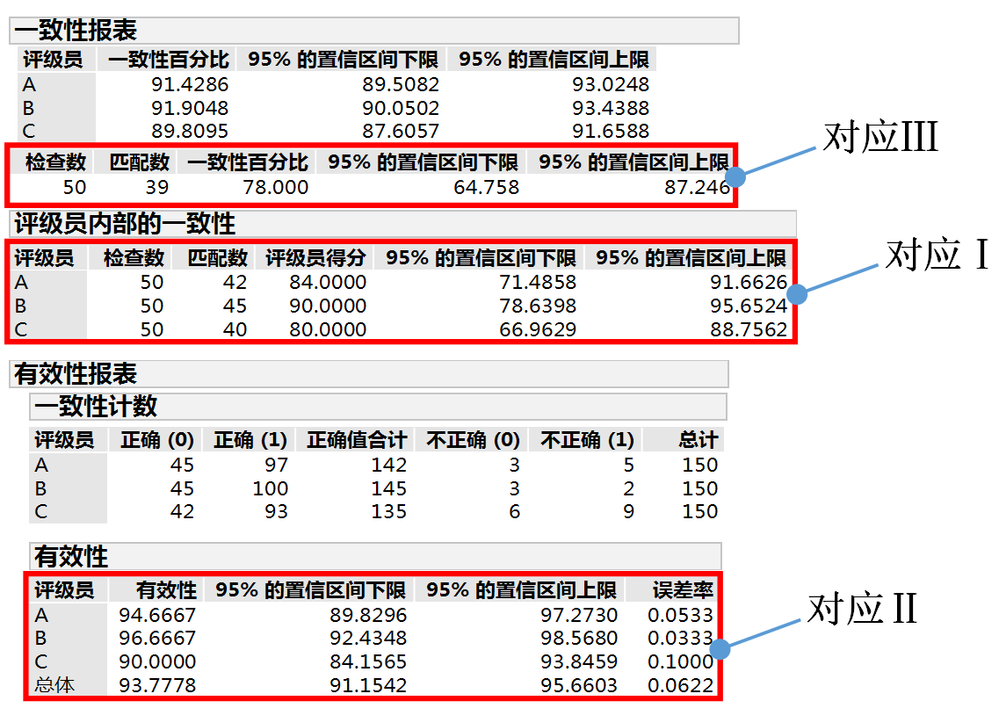

而在JMP中,与之对应的输出报表如图-6所示。值得一提的是,在JMP中,对于Ⅱ评估项的有效性定义为:正确决策数与决策机会总数之比。举个例子,假定评级员A对于某个部件的3次评级,有1个决策不正确(如合格、合格、不合格),那么,另外两个决策仍计为正确决策。这一有效性定义不同于AIAG MSA手册,因为在AIAG MSA手册的定义下,评级员A对该部件的全部3个决策都将计为不正确。其实这两种定义并没有绝对的对错,相对来说,单独计算所有评级决策可以提供整个测量过程的更多信息。对于Ⅳ评估项结果,JMP虽然未直接给出,但也未发现AIAG MSA手册对该评估项设立明确的参考标准。

图-6 JMP计数型测量系统分析有效性研究相关输出报表

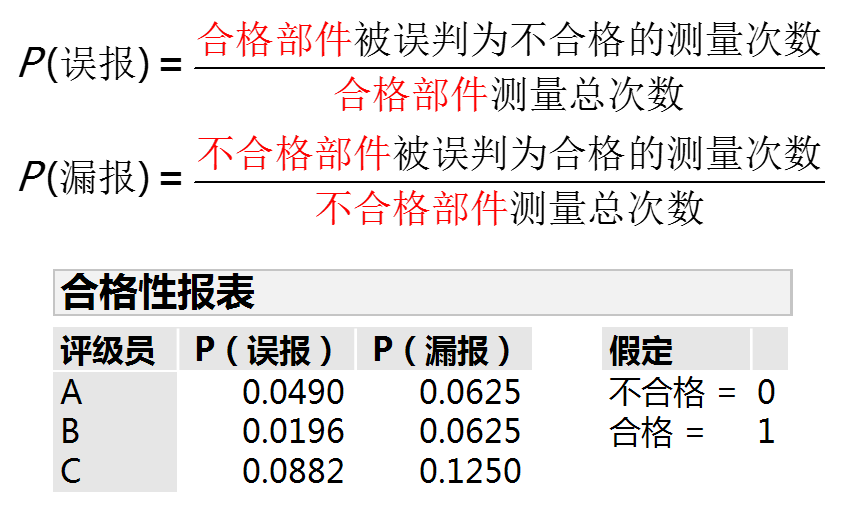

其次,在不同评级员的误报率和漏报率方面,汇总结果如图-7所示。这里的误报率和漏报率分别是指:

图-7 不同评级员的误报率和漏报率汇总报表

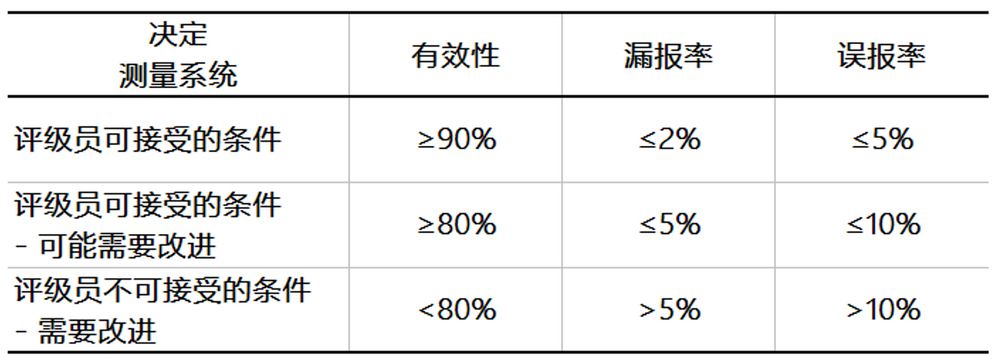

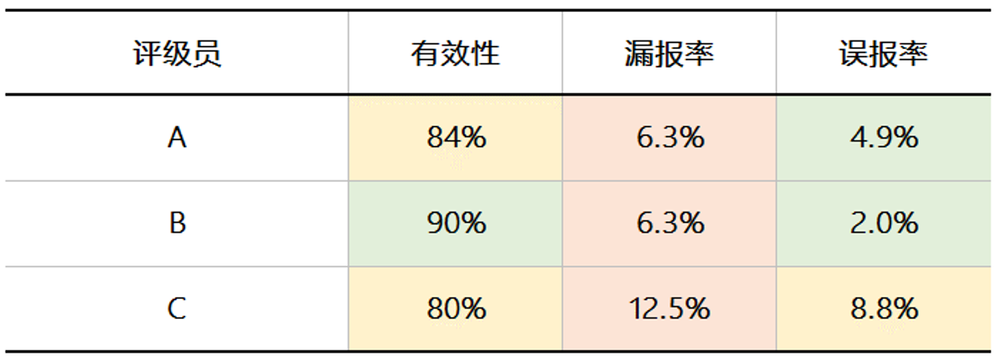

最终,在AIAG MSA手册中,给出了本评估环节中一些定量指标的参考标准示例,如表-3所示,以及本环节的评级员实际评估结果汇总,如表-4所示。

表-3 评级员有效性、漏报率和误报率参考标准示例

表-4 评级员有效性、漏报率和误报率评估结果汇总

通过比对不难看出,如果以当前评级员有效性、漏报率和误报率参考标准为依据,那么没有哪位评级员在3个维度上是完全可以接受的,也没有哪位评级员在3个维度上是完全不可被接受的,问题主要在于漏报率的指标评估上,这似乎在某种程度上与之前的Kappa值统计结论相悖。因此,作为该测量系统分析的研究小组,一方面可以重新审视当前的有效性、漏报率和误报率标准定义是否合理,还是评级员需要更好的培训(特别是评级员代表C),测量系统需要更进一步的改善?另一方面,也可以和内部、外部客户沟通研讨,他们如何看待当前的分析结果,他们的期望和要求又是什么,双方是否可以共同承担当前所反应出来的测量系统风险?因为综合所有分析结果来看,当前的测量系统并非不可有条件的接受。

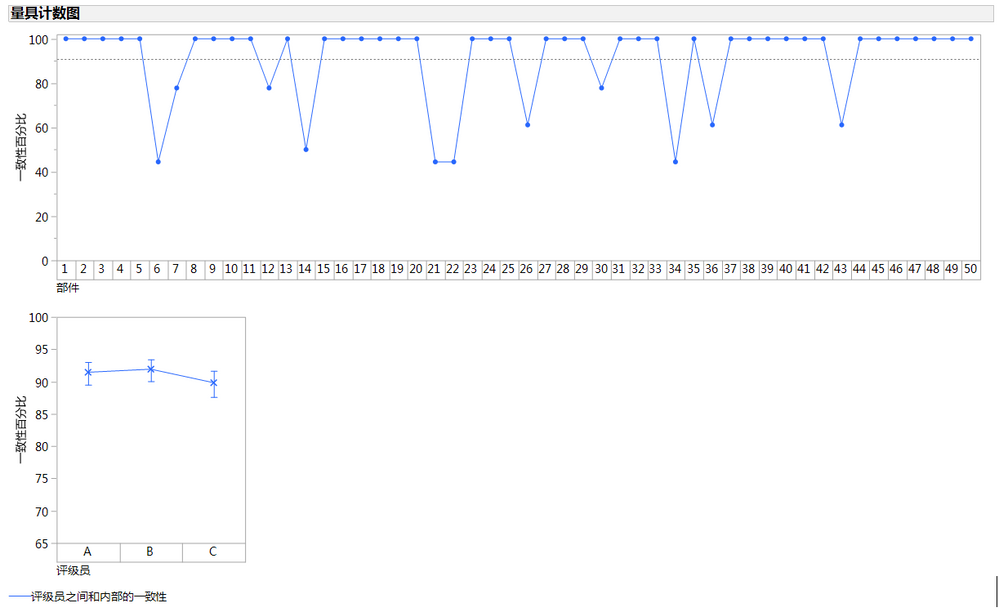

此外,除了上述与AIAG MSA手册相呼应的分析内容外,JMP还给出了一些其它的可视化图表,比如图-8所示的量具计数图。在量具计数图中,你同样不必过于纠结Y轴取值的来历,能够首要明晰在第一个图中,“一致性百分比”值越低的部件,评级员对其给出的测量结果越不一致;在第二个图中,“一致性百分比”值越低的评级员,与其他评级员或是自我评级结果越不一致即可。即为你更进一步地深入分析该计数型测量系统指明了方向,并且也可与其它分析结果相互佐证。

图-8 JMP量具计数图

以上就是我们本期所要介绍的有关计数型测量系统分析的全部内容,希望本文能够帮助你进一步了解JMP在MSA领域的具体应用。

You must be a registered user to add a comment. If you've already registered, sign in. Otherwise, register and sign in.